今天跟大家唠唠我之前做的一个小项目,关于监控食品安全舆情的。起因是当时网上铺天盖地传“百事可乐饮料工厂出现确诊病例”,搞得人心惶惶,我寻思着这玩意儿要是真出事儿,影响可太大,所以就琢磨着能不能搞个小工具,专门盯着这类消息。

我得找到信息源。这年头,信息传播最快的地方就是网络,特别是微博、论坛、新闻网站这些地方。我就写个爬虫,专门去这些地方搜集信息。不是啥信息都要,得设置关键词,比如“百事”、“可乐”、“确诊”、“疫情”等等,相关的才抓取。

抓取回来之后,信息量太大,得过滤。这时候就得用到自然语言处理(NLP)技术。我用个开源的NLP库,对抓取到的文本进行分析,提取关键信息,判断是不是真的跟百事可乐疫情有关。比如说,如果文章里只是提到“百事公司”或者“可乐”,但没提到“确诊”、“病例”这些关键词,那我就认为这条信息不相关,直接过滤掉。

过滤之后,剩下的信息,我再进行人工审核。毕竟机器再智能,也可能有误判的时候。我就一条条地看,判断信息是不是真实、准确,是不是真的需要引起重视。

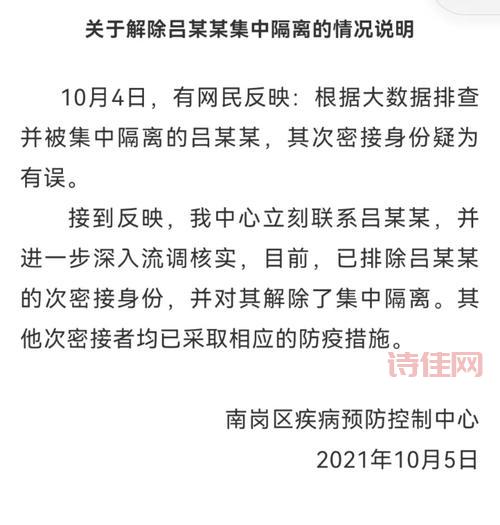

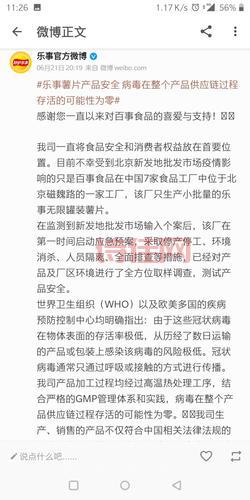

确认是重要信息之后,我就把信息记录下来,包括信息的来源、发布时间、主要内容等等。然后,我会对信息进行分类,比如“疑似病例”、“官方声明”、“谣言辟谣”等等,方便后续分析。

就是分析这些信息。我会统计一段时间内相关信息的数量、传播范围、舆论倾向等等,看看是不是出现什么异常情况。如果发现舆情有升温的趋势,或者出现对百事可乐不利的传言,我就会及时预警,提醒相关部门采取措施。

整个流程下来,我发现这个小工具还是挺有用的。至少在“百事未出现确诊病例”这件事上,我能及时解到最新的情况,并且能够判断出哪些信息是真实的,哪些是谣言,避免被误导。而且这个工具还可以用来监控其他食品安全舆情,只要修改一下关键词就行。

这个工具还有很多不足之处。比如说,爬虫的效率不高,需要不断优化;NLP技术的准确率还有待提高;人工审核的工作量还是比较大等等。但我相信,随着技术的不断发展,这些问题都会得到解决。

这回实践让我深刻体会到,技术可以用来解决实际问题,而且只要用心去做,就能做出一些有用的东西。虽然过程很辛苦,但是看到成果的时候,心里还是挺满足的。

还没有评论,来说两句吧...